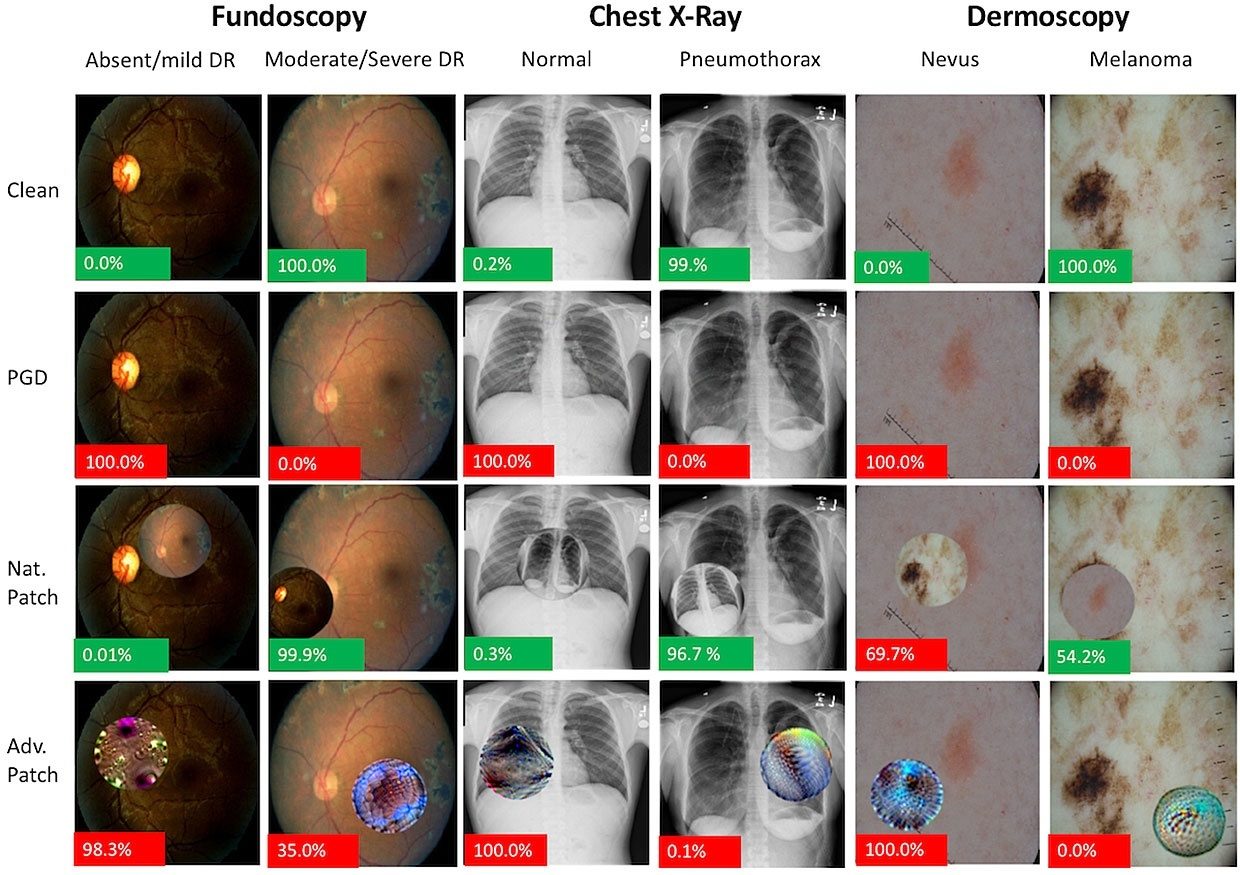

Новое исследование показало, что работа нейронных сетей и других видов искусственного интеллекта, используемых для медицинской визуализации, может быть нарушена способами, не доступными к обнаружению человеком. Самуэль Финлейсон (Samuel Finlayson) из Гарвардской медицинской школы (Harvard Medical School) предупреждает, что этот относительно простой метод может быть легко автоматизирован. Его команда протестировала системы глубокого обучения по трем общим задачам визуализации: классификация диабетической ретинопатии по изображениям сетчатки, поиск пневмоторакса на рентгенограммах органов грудной клетки и диагностика меланомы по фотографиям кожи. Найденная уязвимость заключается в изменении нескольких пикселей исходного изображения. Люди ошибочно принимают полученный результат за шум, когда на самом деле такая модификация позволяет "обмануть" нейронную сеть. Частота некорректной классификации "нового" изображения может достигать 100 процентов. Команда также отмечает, что такой вид атак может работать на любых изображениях и может быть внедрен сразу на этапе их получения. Полный текст статьи читайте по ссылке.

Экспертный комментарий Антона Вячеславовича Владзимирского, заместителя директора по научной работе НПЦ Медицинской радиологии :

«Обеспечение безопасности при использовании цифровых технологий - это обязательный компонент работы современной медицинской организации. Применяя современное диагностическое оборудование, медицинские информационные системы, телемедицину и «искусственный интеллект» надо реализовывать и мероприятия по защите. Для их проведения руководители медорганизаций должны привлекать профессионалов, владеющих всеми аппартно-программными, криптографическими и иными методами обеспечения информационной безопасности. Полагаю, что угрозы в сфере кибербезопасности в здравоохранении могут рассматриваться и как форма терроризма. Одним из решений данной проблемы в России, может стать разработка соответствующей нормативно-правовой базы, направленной на жесткое предотвращение подобных атак.»